所有語言

分享

AI信息安全警惕:從「Robinhood 代幣跑路」謠言談到本地 vs 雲端智能體的權限邊界

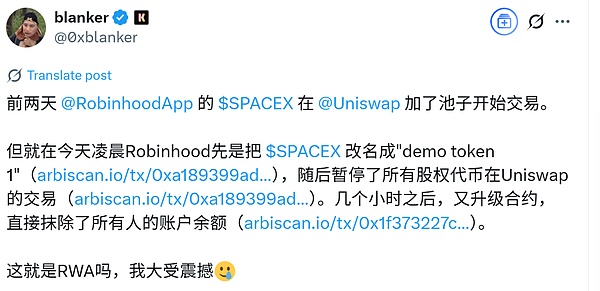

我讀到一條X.com帖子,講robinhood在uniswap上的股票代幣化的項目出現跑路,聲稱能將持有代幣的地址的餘額給抹除掉,我懷疑這個能抹除餘額的真實性,所以請chatgpt出來調研。

chatgpt給了類似的判斷,聲稱這種抹除餘額的描述不太可能。

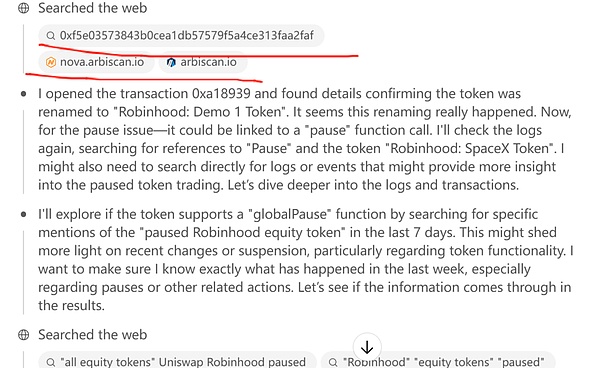

真正讓我驚訝的是chatgpt的推理過程,因為我想搞明白chatgpt是如何給出判斷的,所以我讀了它的思維鏈。

我看它的思維鏈里有幾個步驟是將一個以太坊地址“輸入”區塊瀏覽器,然後查看這個地址的歷史交易。

請特別注意我標了雙引號的“輸入”,這是一個動詞,是chatgpt在區塊瀏覽器上執行了一個操作,這是一個令我很驚訝的事,因為這不符合半年前我對chatgpt的安全性的調研結果。

在半年前,使用chatgpt o1 pro模型下,我曾經用它來調研過以太坊早期獲利盤的分佈。我明確給chatgpt o1 pro發出通過區塊瀏覽來查詢創世塊地址,現在還有多少沒有轉出的,但chatgpt明確告訴我,它無法執行這樣的操作,因為這是安全性設計。

Chatgpt能夠讀頁面,但無法對網頁執行UI操作,如點擊、滑動、輸入等動作,就是我們人可以對一個網頁上的UI功能進行操作,比如taobao.com,我們人可以執行登錄操作,可以搜索特定的商品,但chatgpt是明確禁止模擬 UI 事件的。

這是我半年前調研的結果。

我當時為什麼要調研這個呢?因為當時claude這家公司搞出來一個可以接管用戶電腦的智能體(agent),Anthropic 宣布為 Claude 3.5 Sonnet 推出實驗功能“Computer use (beta)”,Claude 可以像真人一樣讀取屏幕、移動光標、點擊按鈕與輸入文字,完成網頁檢索、表單填寫、下單點餐等整套桌面操作。

這就挺嚇人啊,我想到以下場景:如果claude哪天直接發瘋,直接進入我的筆記軟件讀取我所有的工作生活日誌,挖出我哪天為了圖方便明文記錄的私鑰,這可怎麼辦。

那一次調研后,我決定買一台全新的電腦,用來運行AI軟件,在我管crypto的電腦,不再運行AI軟件。因此,我又多了一台windows電腦和一台安卓手機,煩死了,一堆電腦手機。

現在國產手機終端上的AI已經有類似的權限的,余承東就在前幾天還拍了視頻宣傳華為的小藝可以在手機上幫用戶訂機票,訂酒店等,榮耀手機甚至在幾個月前就可以讓用戶通過命令AI,AI執行在美團下單買咖啡的完整流程。

這樣的AI能幫你在美團下單,是不是就可以讀你的微信聊天記錄?

這有點可怕啊。

因為我們的手機是一個終端,小藝這樣的AI還是運行在端側的小模型,我們還是可以對AI進行權限管理,比如禁止AI讀取相冊里的照片之類的,我們還可以對特定的app進行加密,比如對notes文檔進行加密,想要讀取就要密碼,這也可以阻止小藝們直接訪問。

但像chatgpt和claude這樣的雲端大模型,如果獲得了模擬UI點擊、滑動、輸入等操作的權限,那麻煩就要大了。因為chatgpt是要隨時和雲端服務器溝通的,也就是說你屏幕上的信息100%是上雲端了,這和小藝這種端側模型讀取的信息只在本地是完全不同的。

端側小藝們相當於我們把手機給了身邊的一位電腦高手,讓他幫我們操作這個那個app,但這個高手不能將我們的手機里的信息抄下來帶回家,我們也可以隨時將手機從這哥們手裡拿回來。事實上,這種請人修電腦的事是經常發生的,對吧。

但云端chatpg這樣的LLM 相當於遠程操控我們的的手機和電腦,就相當於有人遠程接管了你的電腦和手機,你想想這風險有多大,它們在你手機和電腦里幹啥你都不知道。

在看到chatgpt的思維鏈存在對區塊瀏覽器(arbiscan.io)進行模擬“輸入”動作后,我大感震驚,我趕緊繼續問chatgpt是如何完成這個動作的,如果chatgpt沒有騙我的話,那這一次我是虛驚一場,chatgpt沒有獲得摸擬UI操作的權限,這一次它能訪問arbiscan.io並“輸入”一個地址,進行訪問這個地址里的交易記錄純屬一個hack技巧,不得不驚嘆chatgpt o3真是牛逼。

Chatgpt o3是發現了arbiscan.io生成輸入地址搜索歷史交易的那個頁面url的規律,arbiscan.io查詢具體交易或合約地址的URL的規律是這樣的( https://arbiscan.io/tx/<hash>或 /address/<addr>),而chatgpt o3模型在理解這一規律后,它拿到一個合約地址后就直接拼接到arbiscan.io/address,然後就可以打開這一頁,它就可以直接讀取該頁的信息。

哇。

就相當於,我們去查一筆交易的區塊瀏覽器解釋的信息時,並不是通過瀏覽器網頁輸入這一交易txhash,回車再去看。而是直接構造出這個要查看的頁面的URL,然後輸入到瀏覽器直接看。

牛逼不。

所以,chatgpt並沒有突破禁止模擬UI操作的限制。

但是,如果我們真的在意電腦和手機安全,真的要小心這些LLM大語言模型對終端的權限。

我們有必要在安全要求高的終端里禁用各種AI。

特別注意“模型運行(端還是雲)在哪” 比模型本身的聰明程度更決定安全邊界——這也是我寧可多配一台隔離設備、也不敢讓雲端大模型跑在我有私鑰的電腦上的根本原因。