所有語言

分享

李開復:不參与“價格戰”、模型盲測國內第一歡迎PK

文章來源:AI前線

作者 | 褚杏娟

“我們的模型表現超過了其他模型,歡迎不認同的友商來 LMSYS 打擂台,證明我是錯的。但在那發生之前,我們會繼續說我們是最好的模型。”李開復在 5 月 21 日的分享會上說道。

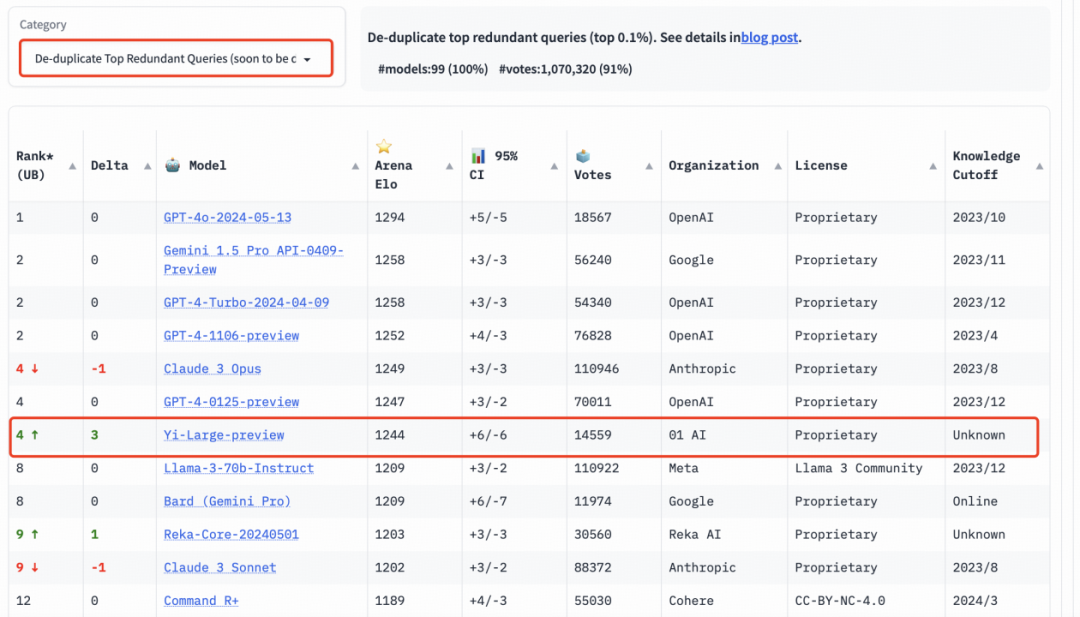

李開復的底氣來自 Yi-Large 一直以來不錯的測評表現。而最近的 5 月 20 日,在 LMSYS 盲測競技場最新排名中,零一萬物的最新千億參數模型 Yi-Large 總榜排名世界第七,中國大模型中第一,已經超過 Llama-3-70B、Claude 3 Sonnet,中文榜更是與 GPT4o 並列第一。

零一萬物也因此成為總榜上唯一一個自家模型進入排名前十的中國大模型企業。在總榜上,GPT 系列佔了前十位的四個名額。以機構排序,零一萬物 01.AI 僅次於 OpenAI、Google、Anthropic,正式進入國際頂級大模型企業陣營。

榜單表現

讓零一萬物振奮的原因是 LMSYS 是大模型金標準,都是第三方匿名,而且每個模型都有數萬用戶評估,結果可信度非常高。OpenAI 的 Sam Altman 和 Google CTO Jeff Dean 都在最近的模型發布中引用了該測試結果。

為了提高 Chatbot Arena 查詢的整體質量,LMSYS 實施了重複數據刪除機制,並出具了去除冗餘查詢后的榜單。這個新機制旨在消除過度冗餘的用戶提示,如過度重複的“你好”。這類冗餘提示可能會影響排行榜的準確性。LMSYS 公開表示,去除冗餘查詢后的榜單將在後續成為默認榜單。

在去除冗餘查詢后的總榜中, Yi-Large 的 Elo 得分更進一步,與 Claude 3 Opus、GPT-4-0125-preview 並列第四。

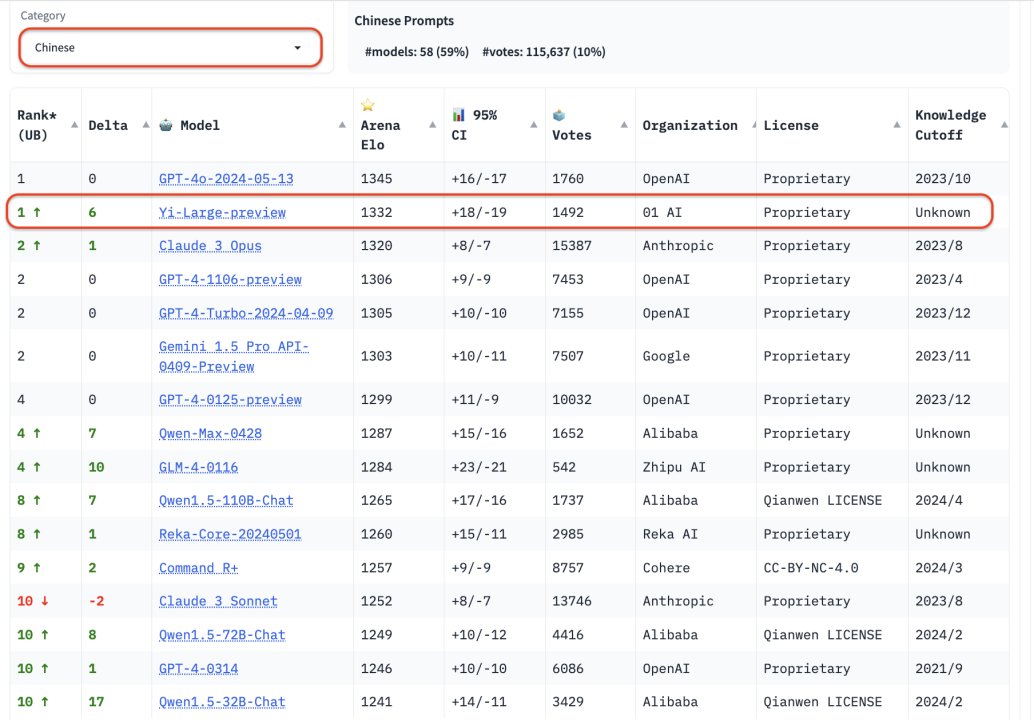

國內大模型廠商中,智譜 GLM4、阿里 Qwen Max、Qwen 1.5、零一萬物 Yi-Large、Yi-34B-chat 此次都有參与盲測。在總榜之外,LMSYS 的語言類別上新增了英語、中文、法文三種語言評測,開始注重全球大模型的多樣性。Yi-Large 的中文語言分榜上拔得頭籌,與 OpenAI GPT-4o 並列第一。

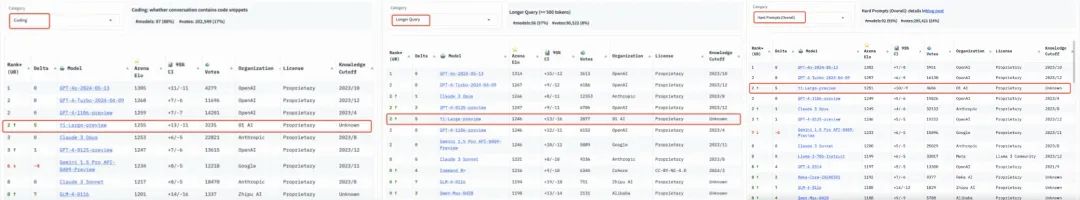

在分類排行榜中,編程能力、長提問及最新推出的 “艱難提示詞” 的三個評測是 LMSYS 所給出的針對性榜單,以專業性與高難度著稱,可稱作大模型“最燒腦”的公開盲測。

在編程能力(Coding)排行榜上,Yi-Large 的 Elo 分數超過 Anthropic 當家旗艦模型 Claude 3 Opus,僅低於 GPT-4o,與 GPT-4-Turbo、GPT-4 並列第二。長提問(Longer Query)榜單上,Yi-Large 同樣位列全球第二,與 GPT-4-Turbo、GPT-4、Claude 3 Opus 並列。

艱難提示詞(Hard Prompts)則是 LMSYS 為了響應社區要求,新增的排行榜類別。這一類別包含來自 Arena 的用戶提交的提示,這些提示則經過專門設計,更加複雜、要求更高且更加嚴格。LMSYS 認為,這類提示能夠測試最新語言模型面臨挑戰性任務時的性能。在這一榜單上,Yi-Large 處理艱難提示的能力也得到印證,與 GPT-4-Turbo、GPT-4、Claude 3 Opus 並列第二。

在此之前,各種靜態榜單幾乎成為廠商必爭的地方。在零一萬物模型訓練負責人黃文灝看來,所謂打榜主要是廠商要把模型某些單一能力做提升,但比較的時候大家可能並不了解,會帶來一些 bias。LMSYS 提供了一種更接近於用戶真實場景的評測方式,所以可以作為一個更好的衡量標準。

李開復:不會對標“價格戰”

用好的模型,貴不貴?當前,Yi-Large API 的定價是 0.02 元 / 千 tokens,大概是 GPT-4 Turbo 成本和定價的三分之一。

成本問題其實是零一萬物一直以來就在關注的。“在大模型時代,模型訓練和推理成本構成了每一個創業公司必須要面臨的增長陷阱。”李開復曾說道。

“我們關注到最近降價的現象,我認為我們的定價還是非常合理的,而且我們也在花很大精力希望它能再降下來。”李開復表示,整個行業每年降低 10 倍推理成本是可以期待的,而且也必然發生的,以這個角度看,現在的降價對整個行業來說就是一個好消息。

但對於大模型公司,李開復認為,國內常看到 ofo 式的瘋狂降價、雙輸的打法,大模型公司不會這麼不理智,因為技術還是最重要的,如果技術不行,純粹靠貼錢、賠錢做生意是行不通的。

李開復以萬知為例介紹到,零一萬物內部也糾結過用 Yi-Medium,中尺寸模型有成本優勢,但是大尺寸模型更有泛化和推理能力優勢。考慮到萬知用戶也包括海外用戶,還是需要最強的推理能力,因此團隊最終選擇了千億參數的 Yi-Large。

“雖然這並沒有達到 TC-PMF、還不能賺錢,但是技術的需求是不可妥協。推出之後,模型和 Infra 團隊就一起快速把錢降下來。”李開復說道。

對於當前的大模型價格戰,李開復明確表示不會對標這樣的(市場)定價。“如果中國市場就是這麼卷,大家寧可賠光、通輸也不讓你贏,那我們就走外國市場。”

“最小到最大的模型,做到中國最好”

在做大模型方面,零一萬物將繼續堅持 Scaling Law。從最小的 6B 到 34B,到現在的千億模型,還有訓練中的萬億 MoE,零一萬物技術團隊明顯看到模型性能隨着參數量的增大,智能水平也在顯著上升,Scaling Law 給 AGI 指明了一個方向。

以大模型為代表的就是大規模機器學習,需要過大量的算力做大量的實驗來得到結論,同時需要算法和 Infra 做聯合優化。

在 Scale up 過程中,最能夠高效使用算力的通用結構一般會獲得較大成功。在模型結構上加了各種各樣的 prior(先驗知識)、去調優可以獲得更好效果,但這些 prior 也是約束條件,對模型效果產生影響。零一萬物發現,最簡單的模型就是最高效的,重要的是怎麼去用好計算能力,而給定算力條件下的智能水平,最重要的是數據的質量和使用數據的效率、計算效率。

黃文灝表示,零一萬物需要算法、Infra 和工程三位一體的人才,但這樣的人在國內並不是很多。大模型研發中,人才的作用被放大,比如算法團隊不需要特別多的人,一般是 10~20 人,但是他們後面是幾萬張卡,這些人的能力就被幾萬張卡放大了很多。

目前,零一萬物的系列大模型參數剛邁入千億行列,但已經可以與 GPT-4、Gemini 1.5 Pro 等萬億級別的超大參數規模模型扳手腕。

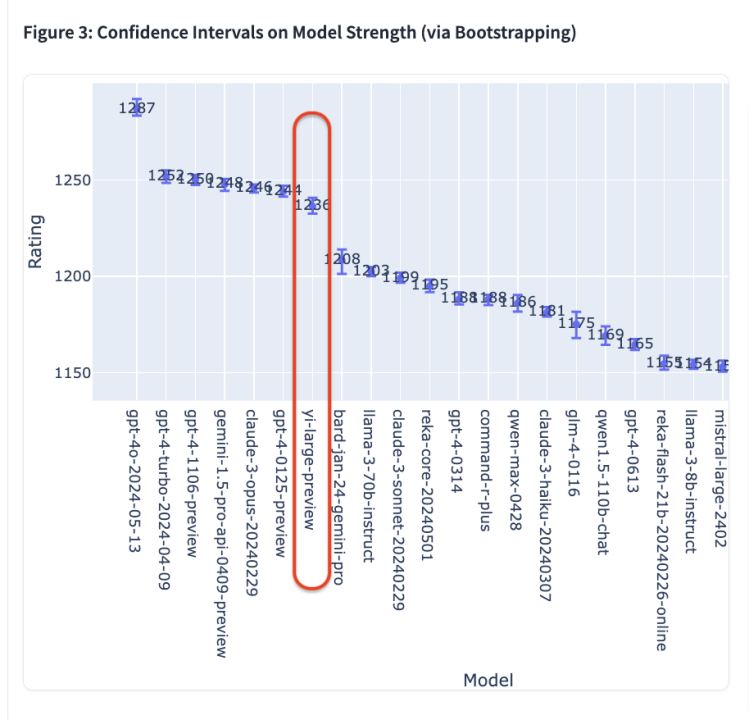

在 Chatbot Arena 測評的 44 款模型中,GPT-4o 在最新的 Elo 評分中以 1287 分高居榜首,GPT-4-Turbo、Gemini 1 5 Pro、Claude 3 0pus、Yi-Large 等模型則以 1240 左右的評分位居第二梯隊;其後的 Bard (Gemini Pro)、Llama-3-70b-Instruct、Claude 3 sonnet 的成績則斷崖式下滑至 1200 分左右。

“我們的計劃是從最小到最大的模型都能夠做到中國最好。”李開復表示。一方面,根據 scaling law,越大尺寸的模型約有可能達到 AGI;另一方面,小一些的模型也有各種應用機會。因此,零一萬物的打法是“一個都不放過”,並且在每一個潛在尺寸上做到性能最高、推理成本最低。

不過另一個現實是,零一萬物 GPU 存量只有 Google、Microsoft 的 5%,但李開復認為這並不代表企業就沒有機會。

“能用同樣一張卡擠出更多的價值,這是今天我們能夠達到這些成果的重要原因之一。”李開復說道。