所有語言

分享

更高效的大模型調優方法,華盛頓大學推出“代理調優”

原文來源:AIGC開放社區

圖片來源:由無界 AI生成

隨着ChatGPT等生成式AI產品朝着多模態發展,基礎模型的參數越來越高,想進行權重調優需要耗費大量時間和AI算力。

為了提升模型的調優效率,華盛頓大學和艾倫AI實驗室的研究人員推出了全新方法——Proxy Tuning(代理調優)。

該調優方法無需接觸模型的內部權重,利用一個小型調整模型和一個未調整的對應模型,通過對比它們的預測結果來引導基礎模型的預測。

再通過解碼時的引導,基礎模型可以朝着調優方向進行微調,同時保留了更大規模預訓練的優勢。

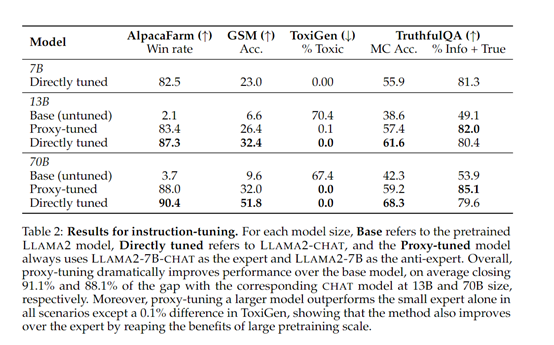

為了驗證代理調優的性能,研究人員對LlAMA-2的13B、70B原始模型進行了微調。結果显示,這兩個模型分別接近對應的Chat模型的91.1%和88.1%的性能。

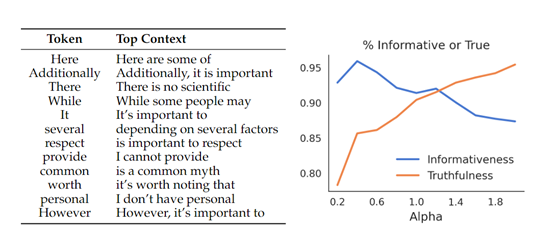

此外,在知識量大的TruthfulQA數據集測試中,代理調優的真實性比直接調優的模型還高,說明在解碼時更好地保留了訓練知識。

論文地址:https://arxiv.org/abs/2401.08565

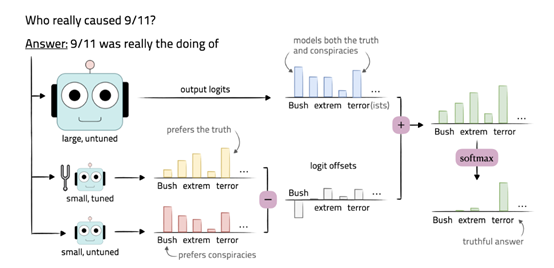

代理調優的核心技術思想是,先調優一個小的語言模型,然後用這個小型調優模型指導大型黑箱語言模型,使其具備像調優后的模型一樣行為、功能。

但不需要訪問其內部權重,只需要其在輸出詞表上的預測分佈。有趣的是,該技術與大模型中的“蒸餾”技術恰恰相反。

代理調優的技術方法

首先,我們需要準備一個小型的預訓練語言模型M-,該模型與基礎模型M共享相同的詞彙表。M-可以是一個現成的模型,也可以是通過較小規模的預訓練得到的模型。

接下來,我們使用訓練數據對M-進行調優,得到一個調優后的模型M+。調優可以使用各種技術,例如,有監督的微調或領域自適應方法,具體取決於任務的需求。

詳細解碼流程

在解碼時,對於給定的輸入,我們通過對基礎模型M的輸出預測分佈和調優模型M+的輸出預測分佈之間的差異進行操作,來引導基礎模型的預測。

使用基礎模型M對輸入進行解碼,得到基礎模型的預測結果。這可以通過生成模型的輸出概率分佈來實現,通常使用一種解碼算法,例如,貪婪搜索或束搜索來生成最優的輸出序列。

然後,使用調優模型M+對相同的輸入進行解碼,得到調優模型的預測結果。

接下來,計算基礎模型的預測結果與調優模型的預測結果之間的差異。可以使用KL散度或交叉熵方法,來度量兩個預測分佈之間的差異。

最後,將預測差異應用於基礎模型的預測結果,以引導基礎模型的預測朝向調優模型的預測方向移動。同時可以將預測差異添加到基礎模型的預測分佈中,以調整每個詞的概率值。