所有語言

分享

英偉達成為全球首家市值 5 萬億美元公司;OpenAI 完成公司重組;Cursor 發布 2.0 版本

據《The Information》報道,OpenAI 已經着手研發一款能夠從文本或音頻提示生成音樂的人工智能模型,並與 Juilliard 音樂學院的學生合作,對樂譜進行註釋以充當訓練數據。這一動向意味着 OpenAI 將把生成式能力從文本與視頻進一步拓展到音樂領域,相關產品形態與上線時間尚未明確。

圖源:網絡

該工具的目標使用場景包括為現有視頻自動配樂、為人聲生成吉他等伴奏,交互方式支持文本與音頻提示,產品形態既可能獨立發布,也可能整合到 ChatGPT 或 Sora 中。就應用範圍而言,預期覆蓋廣告短曲、視頻背景音樂到完整作品等多層級製作需求。

從競爭格局看,OpenAI 的入局將直接對標當前市場上更早布局生成音樂的 Suno、Udio 等公司,亦與 Google 等科技巨頭的相關嘗試形成對比。考慮到 OpenAI 擁有龐大的 ChatGPT 用戶基礎,音樂生成能力若能與其生態深度融合,勢必增強平台黏性與商業化想象空間。

法律與倫理層面,行業對訓練數據來源與版權合規的警惕持續升溫。唱片公司已就訓練材料的版權問題起訴 Suno 與 Udio 等生成音樂平台,凸顯許可、分成與創作者權益的關鍵性挑戰。OpenAI 若推進相關產品,也將面臨類似的許可與風控議題。

OpenAI 並非首次涉足音樂生成:2019 年推出 MuseNet,2020 年發布早期實驗項目 Jukebox,此後階段性淡出該領域。此次重啟音樂生成路線,既延續其多模態模型演進,也反映生成式 AI 向更多創意生產環節滲透。

英特爾 Q3 扭虧為盈:凈利潤 41 億美元,去年同期虧損 166 億美元

英特爾在 2025 年第三季度實現近兩年來首次盈利,營收與多項關鍵指標好於市場預期,显示出在成本收縮與資本加持下的階段性修復跡象。公司披露第三季度營收約 136.5 億美元,超過 LSEG 市場一致預期的 131.4 億美元;按非 GAAP 口徑每股收益為 0.23 美元,但由於與美國政府入股相關的託管股份會計處理,該數據不具可比性。英特爾報告凈利潤 41 億美元,較去年同期 166 億美元虧損大幅好轉。

圖源:英特爾

資本層面,英特爾在過去兩個月獲得多項外部支持,包括美國政府在 8 月以約 89 億美元取得公司 10% 股權,成為第一大股東;英偉達在 9 月以 50 億美元入股並推進 CPU 與 AI GPU 的協同方案;軟銀在 8 月注資 20 億美元。公司同時通過出售 Altera 與 Mobileye 等資產充實現金,管理層稱由此提升了資產負債表韌性與戰略執行靈活性。

業務結構上,客戶端計算業務營收約 85 億美元,同比增長,受 Windows 10 進入生命周期末期、企業與消費者換機需求加速影響;數據中心 CPU 業務約 41 億美元,同比小幅下滑。管理層指出,隨着 AI 應用從試驗走向生產,推理負載對 CPU 的需求提升,疊加超大規模客戶更新老舊服務器,後續數據中心 CPU 需求有望回暖。

供應與產能方面,英特爾坦言當前供給緊張,預計明年一季度短缺將達峰,短期將優先保障服務器與 AI 相關產品的產能與出貨,並對價格與產品結構進行動態調整。面向客戶端的 Panther Lake(基於 Intel 18A 工藝)今年僅推出一個 SKU,更多型號將在 2026 年逐步放量。公司稱 18A 產能與良率“足以滿足供應”,但尚未達到支撐理想毛利的水平;18A 將作為“長生命周期節點”,支撐至少三代客戶端與服務器產品。與此同時,下一代 14A 節點在客戶推動下進展“優於同階段的 18A”,英特爾表示對其更有信心。公司並計劃每年發布新一代 AI GPU,以適應爆髮式的服務器需求。

英特爾代工(Foundry)業務仍是轉型成敗的關鍵。該業務本季度營收約 42 億美元、同比下降 2%,當前收入主要來自公司自用生產。美國政府的投資條款要求英特爾未來五年不得剝離代工業務。英特爾表示已在亞利桑那啟動最先進工藝芯片生產,並與潛在客戶积極接觸,但強調“紀律性增長”,通過流程與客戶生態的適配來建立長期信任。

費用與組織方面,英特爾持續推進降本增效,季度末員工總數降至約 8.84 萬名,較去年同期減少約 29%。展望第四季度,公司給出營收指引區間 128–138 億美元,中位數約 133 億美元,與市場預期大致匹配,非 GAAP 每股收益指引約 0.08 美元。管理層提示,因政府入股的複雜會計處理尚待監管確認,財務結果未來可能調整。

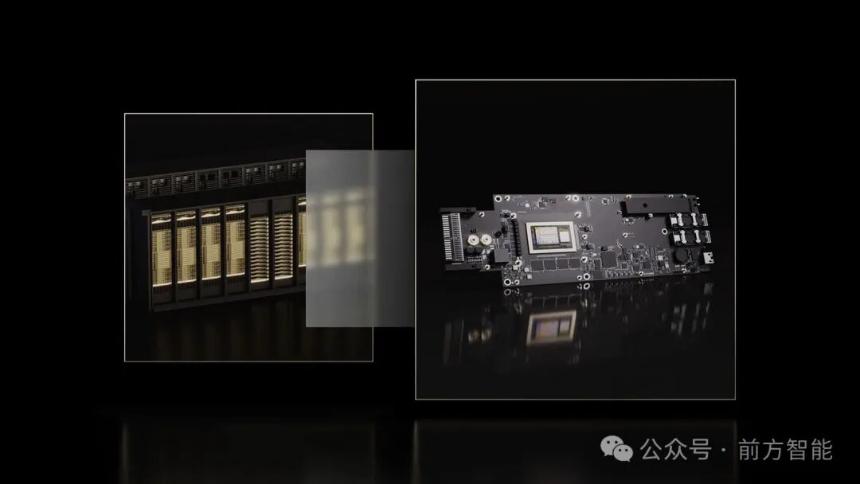

高通發布 AI200 與 AI250 數據中心推理加速器

在 AI 數據中心競賽升溫之際,高通宣布推出面向推理場景的兩款加速器芯片 AI200 與 AI250,並配套整機機架與加速卡形態,計劃分別於 2026 年與 2027 年商用。新產品基於高通長期在移動與 PC 領域使用的 Hexagon NPU 技術,定位於以更優的“性能 / 成本 / 功耗”比,服務大規模生成式 AI 推理。

圖源:高通

高通表示,AI200 單卡支持 768GB LPDDR 內存,強調以更高容量、較低成本滿足大參數量與多模型并行的推理需求;機架方案採用直液冷散熱、PCIe 橫向擴展與以太網縱向擴展,並引入機密計算以實現內存分區加密,機架級功耗為 160kW。AI250 則將採用“近存儲計算”的創新內存架構,宣稱相較 AI200 能提供超過 10 倍的有效內存帶寬,同時顯著降低功耗,面向更高密度與更低能耗的推理集群。

高通此次布局聚焦推理而非訓練,意在切入企業從試點走向規模化生產的關鍵階段。推理工作負載的經濟性正在成為競爭焦點,企業愈發以每 Token 成本、每 Token 能耗、內存容量密度與延遲 SLA 等指標做決策。在這一背景下,強調能效與內存規模的非 GPU 加速器正爭奪特定推理層級的份額。

從生態與產品形態看,AI200 與 AI250 將以可加裝至現有服務器的加速卡形式提供,降低存量機房的改造門檻;軟件方面,高通稱其推理導向的完整棧兼容主流 AI 框架,並支持一鍵部署 Hugging Face 模型與推理優化技術。市場層面,沙特的 Humain 已宣布將從 2026 年起部署高通機架解決方案,目標在本地與全球提供高性能推理服務。

儘管發布信息尚未披露具體算力、功耗曲線與核心架構細節,且 AI250 定檔 2027 年使得對其競爭力的全面評估仍需時間,但在英偉達、AMD 之外,推理芯片供應的多樣化趨勢正在形成。

AMD 與美國能源部合作,將斥資 10 億美元打造兩台 AI 超級計算機

AMD 與美國能源部(DOE)宣布達成總額 10 億美元的合作,將在田納西州橡樹嶺國家實驗室(ORNL)建設兩台新一代超級計算機,分別命名為 Lux 與 Discovery,用於加速從核能與聚變研究到癌症治療、國家安全等多領域的重大科學任務。

圖源:ORNL

Lux 預計最快在未來六個月內上線,時間窗口約為 2026 年初;更先進的 Discovery 計劃於 2028 年交付、2029 年投入運行。此次項目由 DOE 承載場地與運營,AMD、HPE 與 Oracle 等夥伴提供設備與資本開支,政府與企業將共享算力資源。

兩台新機均以 AMD 技術為核心:Lux 採用 MI355X 人工智能加速芯片,並整合 AMD 的 CPU 與網絡芯片,ORNL 主任 Stephen Streiffer 表示其 AI 能力約為當前超算的 3 倍;而 Discovery 將基於 MI430 系列,面向高性能計算與 AI 的融合工作負載,強調“Bandwidth Everywhere”的架構理念,在與 ORNL 的 Frontier(曾為全球最快超算)同等成本下提升性能與能效,並支持與 Frontier 的工作負載兼容遷移。

合作方強調該項目的科學使命與應用落地。能源部長 Chris Wright 稱兩台系統將“超級加速”核能、聚變、國防與藥物研發等關鍵領域;他對聚變前景表達樂觀,認為藉助 AI 與超算的推進,有望在兩到三年內探索出可行的“實用路徑”;同時希望在五到八年內將多數癌症從“終極絕症”轉變為可管理疾病。

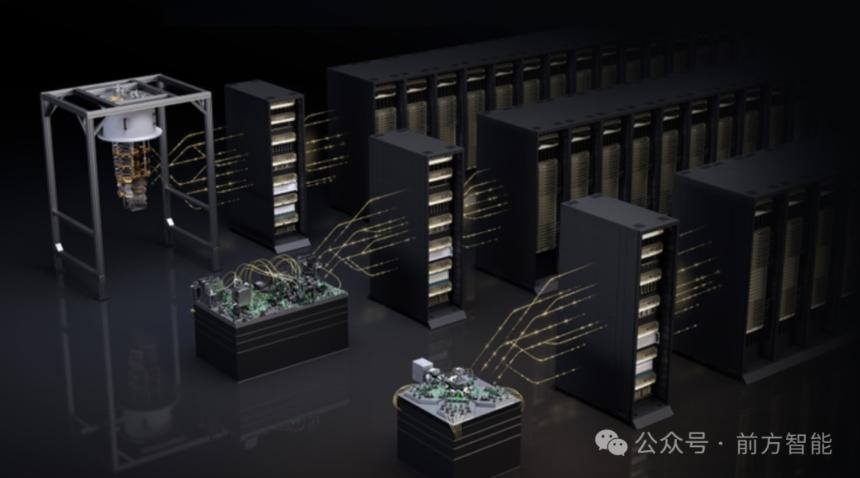

英偉達 GTC DC 全面發力:量子—經典互聯、AI 超級計算機、數據中心“操作系統”齊上陣

10 月 28 日,在華盛頓舉辦的 GTC DC 上,英偉達以“全棧”路線同時推進科研、企業與政府的 AI 基礎設施:與美國能源部及 Oracle 共建七台 AI 超級計算機;推出連接量子處理器與 GPU 超算的新型互聯 NVQLink;發布面向數據中心的 BlueField‑4 DPU;並與 Palantir、HPE 等深化合作,將 AI 從研發推向運營與合規落地。這一系列產品將被為美國下一輪工業與科學復興提供充實的算力基礎。

首先,英偉達與美國能源部、甲骨文合作將於伊利諾伊州阿貢國家實驗室部署兩階段 AI “工廠”:第一階段的 Equinox 將配備 10000 個 Blackwell GPU,第二階段 Solstice 規模擴至 100000 個,二者互聯后合計可達約 2200 exaFLOPs 的 AI 計算性能,用於前沿模型與“代理型科學家”研發,提升公共科研生產率。Equinox 預計 2026 年上線,Solstice 時間未定。

圖源:英偉達

在洛斯阿拉莫斯國家實驗室,英偉達與 HPE 將基於下一代 Vera Rubin 平台建設兩台新系統 Mission 與 Vision:前者面向國家核安全局的保密仿真任務,後者服務於公開科學與 AI 研究,二者計劃於 2027 年投入運行,延續並超越該實驗室 Venado 的開放科研成果。此舉显示 Rubin 平台在保證 AI 低精度推理能力的同時,不犧牲高性能計算的 FP64 科學計算吞吐。

圖源:英偉達

量子方向上,英偉達發布的 NVQLink 被定位為量子—經典超算“羅塞塔石”:通過低時延、高吞吐的開放互聯,將量子處理器 QPU 與 GPU 超算深度耦合,以滿足量子誤差校正、標定與控制算法對經典計算的嚴苛實時性需求,並已與多家量子硬件商及美國多所國家實驗室協同研發,未來混合式量子—經典架構有望成為科研標配。

圖源:英偉達

數據中心“操作系統”層面,BlueField‑4 DPU 集成 64 核 Grace CPU 與 ConnectX‑9 SuperNIC,面向 Spectrum‑X 以 800Gb/s 吞吐加速網絡、存儲與安全等基礎設施任務,相比 BlueField‑3 計算力提升約 6 倍,並通過 DOCA 微服務實現多租戶網絡、快速數據訪問與 AI 運行時安全,目標是在 2026 年隨 Vera Rubin 平台率先早期供貨。該產品將 GPU 算力專用於訓練/推理,把數據搬運、協議棧與零信任安全下沉至 DPU,從而提升整場景效率與可控性。

面向政府與受監管行業的合規部署,HPE 宣布與英偉達擴展“AI Computing by HPE”組合,推出第二代小型化 HPE Private Cloud AI,採用 ProLiant DL380a Gen12 與 RTX PRO 6000 Blackwell Server Edition,實現基於 MLPerf 的三倍價格—性能提升,並提供“空氣隔離”管理選項滿足數據主權與隔離要求;其統一數據層結合 Alletra Storage MP X10000 與與英偉達協作開發的 S3oRDMA,顯著降低延遲與 CPU 佔用,並支持在離線環境運行。HPE 亦推出面向超大模型的 GB300 NVL72 by HPE 與支持 8× Blackwell Ultra B300 GPU 的 ProLiant XD685,通過液冷與整機架 NVLink 提供千兆級參數規模訓練能力。

總體看,本次 GTC DC 的核心信號是:英偉達正以開放互聯、參考設計與軟件棧貫通量子、超算、數據中心與行業運營,將“AI 工廠”從單點算力建設升級為跨算力形態、跨數據域、可治理且可運營的系統工程。

英偉達斥資 10 億美元入股諾基亞,攜手推進 6G 網絡

10 月 28 日,英偉達(Nvidia)宣布以約 10 億美元認購諾基亞(Nokia)新發行股份,雙方同時達成戰略合作,將在無線網絡設備與數據中心網絡領域深度整合雙方的加速計算技術、AI 能力、光纖通信技術,以推動從 5G‑Advanced 向 6G 的演進與 AI 原生網絡落地。

圖源:英偉達

根據披露條款,英偉達將認購諾基亞新發行的 1.66 億股,認購價每股 6.01 美元,交易完成后英偉達將持股約 2.9%。受消息提振,諾基亞股價當日一度上漲逾兩成,創多年最大漲幅。

此次合作的核心聚焦於將 AI 引入無線接入網(AI‑RAN)以提升頻譜與能效,同時在同一加速化平台上統一 AI 與 RAN 工作負載,支持更低時延的邊緣推理。英偉達同步發布面向電信的 6G‑ready 加速計算平台 Aerial RAN Computer Pro(ARC‑Pro),並稱諾基亞將把其 5G 與 6G 軟件適配至 CUDA 平台並將 ARC‑Pro 嵌入新一代 AI‑RAN 方案。雙方還計劃在數據中心交換與以太網方面合作。

OpenAI 完成公司重組,微軟持股 27%

在監管審查與長達一年多的談判后,OpenAI 宣布完成公司重組:其營利實體重組為公共利益公司 OpenAI Group PBC,非營利主體更名為 OpenAI Foundation 並繼續控股營利公司。重組同步落地的與微軟的新協議,明確了雙方在 2032 年前的技術與知識產權安排,並引入獨立專家評審機制來驗證何時達到 AGI。

圖源:微軟

新協議下,微軟在 OpenAI Group PBC 中持有約 27% 股權,賬麵價值約 1350 億美元,並保留對 OpenAI 模型與產品的獨家知識產權直至 2032 年(含 “post‑AGI” 模型,配套安全護欄);對研究方法的知識產權則最遲延續到 2030 年或專家組確認達到 AGI 之時,以先到者為準。與以往不同的是,AGI 的宣布不再由 OpenAI 單方認定,需經獨立專家核驗,這一機制將決定雙方收入分成與研究 IP 權利的截止點。微軟的權利明確不涵蓋 OpenAI 的消費級硬件。雙方也放寬了互相排他:OpenAI 可與第三方聯合開發部分產品(API 類需部署在 Azure,非 API 類可選擇任意雲),微軟則可獨立或與第三方探索 AGI。OpenAI 同時承諾額外採購 Azure 服務總計 2500 億美元,但微軟失去對其算力採購的優先拒絕權。

從資本與治理看,重組后 OpenAI Foundation 持有營利公司約 26% 股權,當前估值約 1300 億美元,並在達到特定估值里程碑后享有額外認股權。基金會宣布首期 250 億美元投入兩大方向:健康與治癒疾病,以及面向 AI 的技術性韌性與風險最小化舉措;董事會層面保留對營利公司安全工作的監督。

儘管協議細節較為全面,外界仍關注兩點懸而未決:其一,獨立專家的組成人選與 AGI 驗證標準尚未公開;其二,OpenAI 計劃推出的消費級硬件如何與現有生態銜接,而該硬件明確被排除在微軟的 IP 權利之外。

英偉達成為全球首家市值 5 萬億美元公司

美國芯片巨頭英偉達(Nvidia)周三盤中與收盤雙雙站上 5 萬億美元市值關口,創下全球上市公司歷史新高。受此帶動,科技股集體走強,蘋果、微軟近期也相繼觸及或重返 4 萬億美元市值區間。此次里程碑出現在今年以來英偉達股價大幅攀升的背景下,年內累計漲幅已超過 50%。

圖源:Yahoo Finance

市場情緒的快速升溫與英偉達在華盛頓舉辦的 GTC 大會密切相關。首席執行官黃仁勛宣布,到 2026 年底公司對 Blackwell 與 Rubin 兩代 AI 加速器的累計訂單“可見度”已達 5000 億美元,並與美國政府合作建設 7 座超算中心。此外,英偉達公布與 Uber 的自動駕駛車隊合作、與 Palantir 的企業 AI 協作、向製藥企業 Eli Lilly 提供 1000 塊 GPU,以及出資 10 億美元入股 Nokia 以推動 6G 網絡與通信設備的本土化;公司還發布面向量子計算的 NVQLink 開放架構,連接量子芯片與 GPU 以加速誤差校正與應用落地。這些舉措幫助投資者強化對英偉達長期收入與生態版圖的信心。

受美國出口管制影響,英偉達當前在中國大陸的高端 AI 芯片銷售幾近停擺,但美國總統唐納德·特朗普表示將與黃仁勛討論 Blackwell 芯片對華出口的可能性;此前有關對中國銷售按營收比例分成 15% 的許可安排仍待立法落實。若對華市場部分重啟,有望為英偉達的訂單與收入帶來額外上行空間。

SK 海力士三季度創紀錄盈利,明年 HBM 及存儲產能已售罄

SK 海力士在 AI 浪潮帶動下業績飆升,近日公司披露 2025 財年第三季度營業利潤達 11.4 萬億韓元,同比大增 62%,創歷史新高;營收 22.4 萬億韓元,同比增長 39%。受面向 AI 數據中心的高帶寬內存 HBM 及高性能 DRAM、企業級 eSSD 需求驅動,產品結構與價格同步改善。

圖源:網絡

公司表示,隨着 AI 應用從訓練轉向推理,服務器側對高性能內存的需求持續升溫,HBM 供需緊張將難以在短期內緩解。SK 海力士已與主要客戶完成明年 HBM 供應談判,預計今年第四季度開始供應 HBM4,並在明年擴大銷售。管理層稱“明年包括 DRAM、NAND 與 HBM 在內的產能基本售罄”,部分客戶已提前鎖定 2026 年常規存儲產品。

在資本規劃方面,SK 海力士將“實質性增加”投資,通過 M15X 等項目加速先進工藝轉換、擴充產能,以應對超預期的客戶需求。公司估計 AI 大型項目(包括與 OpenAI 的預協議)帶來的 HBM 內存需求將超過當前行業總產能的兩倍,並將建立相應的生產體系以滿足訂單。

行業層面,諮詢機構數據显示 SK 海力士在全球 HBM 市場份額過半,三星與美光加速追趕;分析師普遍預計 HBM 市場未來幾年將保持高增,供不應求態勢或延續至 2027 年。同時,AI 推動的高性能芯片生產擠占傳統內存產能,DRAM 與 NAND 價格與出貨回暖。受利好刺激,SK 海力士股價年內已大幅上漲。

Cursor 發布 2.0 版本與自研編碼模型 Composer

10 月 29 日,AI 編碼平台 Cursor 推出重大更新:發布自研編碼模型 Composer,並上線以代理為中心的 Cursor 2.0 版本。

圖源:Cursor

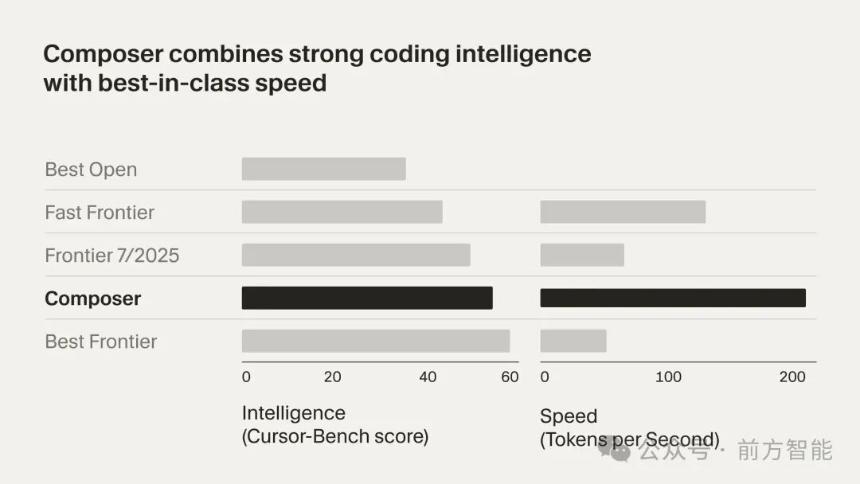

Composer 旨在低延遲的代理式編碼場景下保持前沿智能與高速響應,聲稱較同等智能模型速度提升約 4 倍,絕大多數任務在 30 秒內完成。Composer 通過覆蓋整個代碼庫的語義搜索等工具進行訓練,強化對大型與複雜代碼庫的理解與導航能力;其架構為混合專家 MoE,並在多樣化開發環境中通過強化學習進行后訓練,支持長上下文生成與推理。

圖源:Cursor

Cursor 2.0 在產品形態上轉向“以代理為中心”,支持并行運行多個代理,底層由 git worktree 或遠程機器隔離工作空間,便於同時比較不同模型輸出並擇優採用。在工程工作流上,該版本針對“代碼評審”和“變更測試”兩大瓶頸提供原生支持:集成瀏覽器工具以便代理自動運行與測試代碼、聚合多文件 diff 以加速審閱,並可在需要時深入代碼細節。這一組合旨在讓代理從規劃、編寫到測試與修復更趨自動化,提升複雜多步驟任務的端到端完成度。

Cursor 表示 2.0 現已開放下載,繼續支持多家第三方前沿模型,同時以 Composer 作為快速、可靠的代理式編碼核心,面向專業團隊的并行協作與高效審查測試場景。