所有語言

分享

A16z宣布開源 AI 資助計劃,首批支持8個開源人工智能社區

來源:阿法兔研究筆記

原標題:《A16Z 剛剛官宣支持8個開源人工智能社區》

A16Z相信,人工智能具有拯救世界的力量,而繁榮的開源生態系統,對於構建建設並實現這個未來,至關重要。

值得慶幸的是,開源生態系統正在逐步開始發展,大家現在看到的開源項目和模型,可以與閉源方案相媲美。數以百計的小型團隊和個人,正在不斷給這些開源模型做出貢獻,從使這些模型更加有用、易用和高性能。

正是這些項目和付出,共同推動了開源AI技術的發展,並幫助更多人對新技術有了更深入、更全面的了解。

這些開源項目包括:

對基礎 LLM 進行指令調整:instruction-tuning base LLMs

取消對 LLM 輸出的審查:removing censorship from LLM outputs

為低功率機器優化模型:optimizing models for low-powered machines

為模型推理構建新穎的工具:building novel tooling for model inference

研究 LLM 的安全問題:researching LLM security issues;

等等,然而,這些項目背後的人員往往沒有足夠的資源來完成或長期保持他們的工作。這種情況,在AI領域比傳統計算機基礎設施領域更為嚴重,因為即使是對模型進行基本的 fine-tuning,也需要大量的 GPU 計算資源,尤其是當開源模型變得越來越大時。

為了彌補這一資源缺口,A16Z今天宣布了 a16z 開源 AI 資助計劃,A16Z將通過資助(而非投資或 SAFE 票據)的方式,為一小部分開源開發者提供支持,讓他們有機會在沒有經濟回報壓力的情況下繼續工作。

這裏公布了首批資助對象和資助項目:

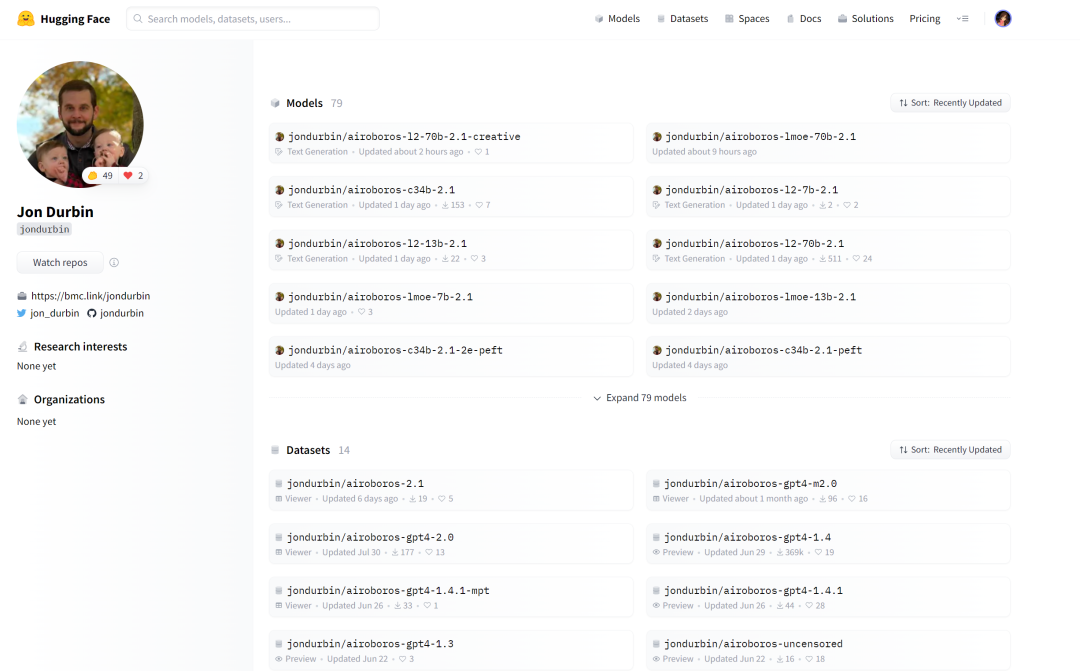

Jon Durbin(Airoboros):instruction-tuning LLMs on synthetic data

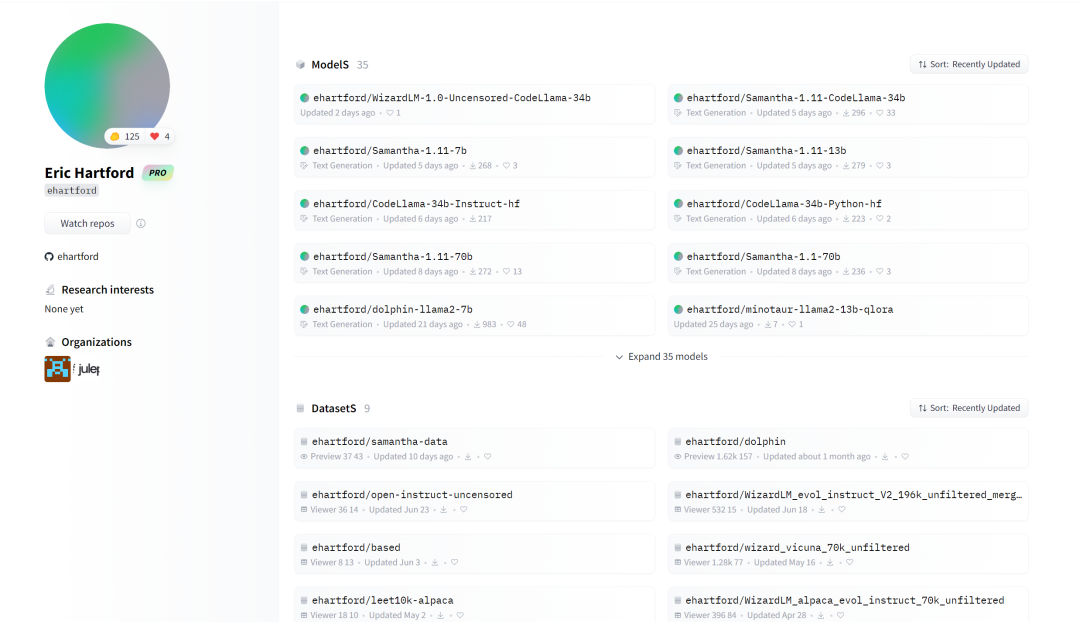

Eric Hartford:fine-tuning uncensored LLMs

Jeremy Howard(fast.ai):fine-tuning foundation models for vertical applications

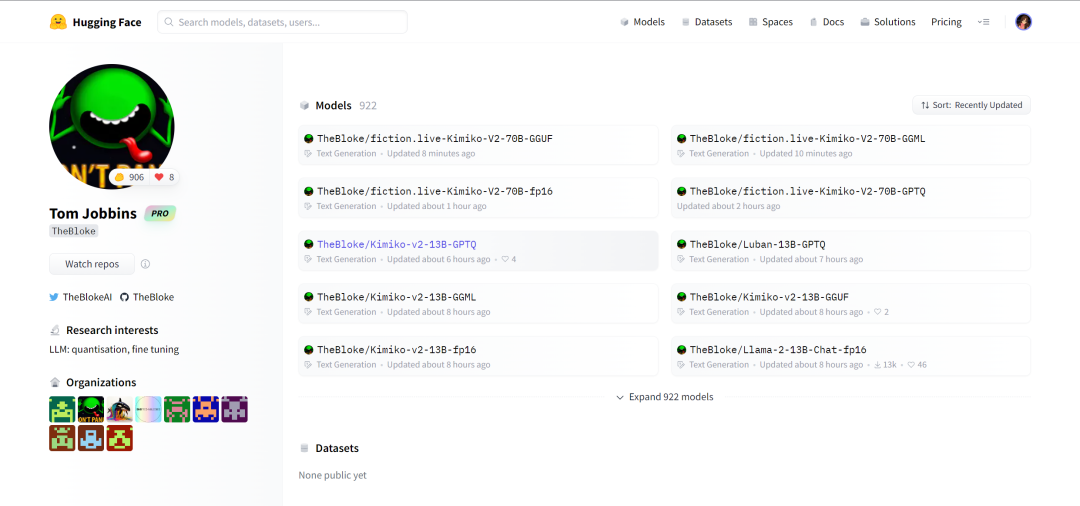

Tom Jobbins(TheBloke):quantizing LLMs to run locally

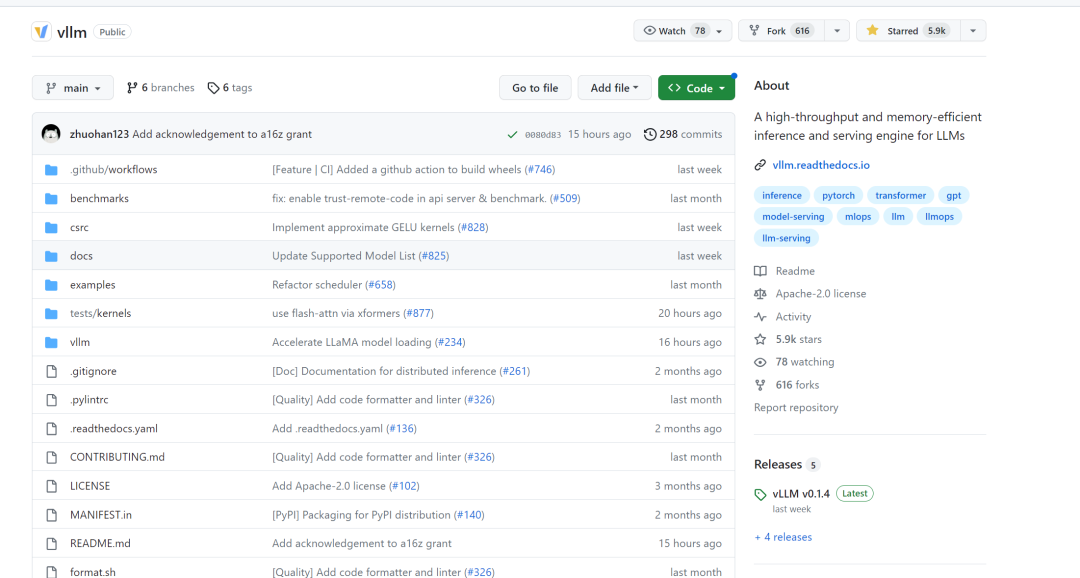

Woosuk Kwon和Zhuohan Li(vLLM):library for high-throughput LLM inference

Nous Research:new fine-tuned language models akin to the Nous Hermes and Puffin series

https://nousresearch.com/

obabooga:web UI and platform for local LLMs

Teknium:synthetic data pipelines for LLM training

感謝他們為這個領域做出的貢獻,正是這些開源社區的開發者,促進了人工智能領域的開放合作、學習和進步。

參考資料:https://a16z.com/2023/08/30/supporting-the-open-source-ai-community/